Corriente anormal lleva la Gulf-Stream hacia Groenlandia

Finalmente en la página en inglés

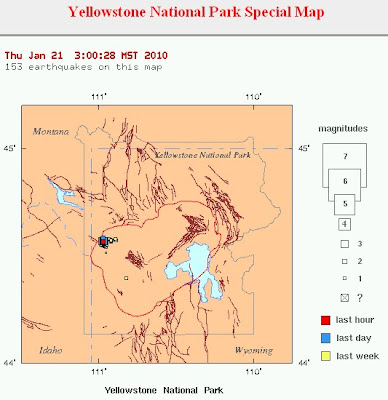

http://www.dailykos.com/, conseguí respuesta a mi inquietud sobre la posible influencia de la corriente del Golfo en el comportamiento inusual de la ola de frío polar. Claro, yo pensé que como el Atlántico esta más frío, la corriente del Golfo también, pero según el artículo, la corriente cálida del Golfo "consiguió una conexión hacia el mar de Groenlandia" en un hecho sin precedente.

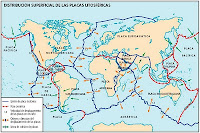

He traducido el artículo y en el mismo podemos interpretar que : "Una circulación atmosférica sin precedentes ha conducido una fuerte corriente directa de unión (conexión) entre la corriente del Golfo y la corriente de Groenlandia. Este es un acontecimiento excepcional. Aunque estos acontecimientos meteorológicos tan excepcionales han sido predichos, la conexión inusual podría ser una variación natural de tiempo y corrientes..." "El aire caliente sobre el Océano Artico y Groenlandia, redujo la marcha de la formación de hielo en el mar. El hielo en el Mar de Labrador disminuyó a finales de diciembre pasado como consecuencia de esta fuerte corriente de conexión, que trajo agua caliente por encima de la costa occidental de Groenlandia"

También agrega: "El pasado da pistas a lo que podría estar ocurriendo en el Atlántico Norte. Recientes investigaciones sobre paleoclimas muestran que agua muy caliente del Gulf-Stream penetró muy al norte en los mares entre Groenlandia y Noruega en el Paleozeno, antes de las glaciaciones del Pleistozeno. La USGS trazó un mapa Sinóptico (el PRISMA) con valores actuales para reconstruir las posibles condiciones globales futuras, y tratar así de entender la dinámica del clima. Los resultados previos indican que hay diferencias de temperaturas entre las ocurridas antes de la glaciación y las actuales, en la latitud Norte (Dowsett et al. 1992), toda vez que las aguas actuales no están aún tan cálidas como entonces. Es decir, para ese periodo, las temperaturas cercanas al ecuador eran similares a las temperaturas actuales, pero no así en las latitudes más altas, pues eran varios grados más calientes que hoy en día."

Pienso, que esta anormalidad ha sido un aviso.

Publicado el 11-01-2009: El sábado les comenté el inusual desvio de la ola de frío hacia el sur, debido a un frente de alta presión que impidió su normal circulación hacia arriba. Hoy, Omar Baddur de la Organización Meteorológica Mundial (OMM) señala lo siguiente: "La ola de frío polar que afecta desde hace varias semanas a una gran parte del hemisferio norte se debe a un fenómeno conocido pero poco frecuente de "bloqueo" de la circulación del aire. Por el momento es "demasiado pronto" para establecer un vínculo entre las temperaturas glaciales registradas en algunas regiones con el fenómeno de El Niño, indicó. El Niño es calentamiento cíclico de las aguas del océano Pacífico ecuatorial que provoca manifestaciones atmosféricas inhabituales en el mundo entero. Por ahora "la única explicación" de la ola de frío "es una situación meteorológica de bloqueo", agregó. El fenómeno de bloqueo se caracteriza por un cambio de la circulación del aire que se hace habitualmente en invierno en el hemisferio norte, del oeste hacia el este. "La ondulación se hace del norte hacia el sur. Cuando esa ondulación es muy vasta, a escala planetaria y persiste varias semanas, se habla de bloqueo", explicó Baddur. Actualmente hay tres ondulaciones, con aire frío que desciende directamente del polo norte, en tres zonas distintas, señaló Baddur. Una en Estados Unidos y México, otra en un eje meridional que cubre toda Europa del oeste (desde los países escandinavos hasta el oeste del Mediterráneo, pasando por Gran Bretaña, Francia, Alemania y España) y una tercera en Rusia oriental y China. "Un bloqueo a tal escala no se produce muy seguido, podemos decir cada 30-50 años", dijo Baddur. El bloqueo actual se está terminando, agregó el especialista de la OMM."En general dura varias semanas, entre un mes y un mes y medio. Comenzó en diciembre por lo tanto llegamos al final", afirmó Baddur."

Por otra parte el representante de la Aemet ha asegurado que es "normal" que se produzcan periodos de dos o tres días de frío intenso como los que se han registrado, pero "lo que no puede considerarse tan normal es que nieve en cotas muy bajas como ocurrió el domingo en Córdoba y pueblos de Sevilla. Esta situación se ha producido, debido a la combinación de una masa de aire húmedo de componente oeste con el aire frío existente en niveles muy bajos.

En México: La masa de aire polar que originó el frente frío número 22 afecta a al menos 20 entidades del país, por lo que continuará la alerta en las próximas 48 horas debido a las heladas, potenciales lluvias y temperaturas de ocho grados bajo cero que en las últimas horas causaron la muerte de tres personas en el estado de Nuevo León. En Durango, el termómetro alcanzó el fin de semana 11 grados bajo cero. En Zacatecas el termómetro marcó ocho grados bajo cero.

En China: Las bajas temperaturas que sufre China desde principios de año han causado que una parte del mar en las costas del norte del país se haya congelado, una situación poco habitual otros inviernos, informó hoy la agencia oficial Xinhua. Según los responsables marítimos estatales, se trata de la "más grave situación de los últimos años" en las aguas que bañan la provincia costera de Shandong, y podría empeorar en los próximos días ya que se espera que las bajas temperaturas continúen. El hielo, por ejemplo, ha sorprendido a más de 200 barcos pesqueros en la bahía de Jiaozhou, que se encuentran bloqueados allí a la espera de que el hielo se derrita. Otro peligro que conlleva la situación es el desprendimiento de grandes bloques de hielo de estas capas, amenazando la navegación marítima. La ola de frío ha causado problemas de transporte y energéticos en todo el país asiático, especialmente en el norte, donde ciudades como Pekín sufrieron poco después de Año Nuevo las peores nevadas en seis décadas.

En Ucrania: Al menos 169 personas murieron por hipotermia en Ucrania, 46 de ellas en sus casas, en lo que va de invierno, como consecuencia de las bajas temperaturas, informó hoy el ministerio de Sanidad ucraniano. Según los datos actualizados hasta el mediodía de hoy, 2.317 personas acudieron al hospital por congelación, de los cuales 1.548 fueron ingresados porque su vida corría peligro.

Océanos absorben más CO2 de lo esperado: Lei tres artículos en inglés publicados en http://www.sciencedaily.com. El primero indica "La mayor parte del dióxido de carbono emitido por la actividad humana no permanece en la atmósfera, sino que es absorbido por los océanos y ecosistemas terrestres. De hecho, sólo aproximadamente el 45 por ciento de las emisiones permanecen en la atmósfera ". El segundo confirma "Nuevos datos muestran que el equilibrio entre la emisión de dióxido de carbono y la fracción absorbida por la atmósfera ha permanecido aproximadamente constante desde 1850, a pesar que las emisiones se han elevado de 2 mil millones de toneladas por año desde 1850, a 35 mil millones de toneladas por año a la fecha. Esto sugiere que ecosistemas terrestres y océanos tienen una capacidad mucho mayor para absorber CO2 de lo esperado". El tercero, publicado hoy, señala "Un equipo internacional de científicos conducidos por la UEA, ha desarrollado un nuevo método de medir la absorción de CO2 del Atlántico Norte completo, y ha trazado un mapa de los resultados... El nuevo método estima el flujo y como varía de año en año y con cada estación, con un detalle nunca antes realizado. Métodos similares podrían ser establecidas en otros océanos y los resultados podrían ser usados para detectar cualquier debilitamiento en la respuesta de absorción del dióxido de carbono por parte de los océanos. Los resultados son importantes para analizar los efectos de subida de CO2 en la atmósfera."

En http://oraculodeoccidente.wordpress.com, hay interesantes publicaciones y comentarios relacionados al tema. Alli comenté, que es irónico que el planeta sufra en este momento una ola de frío extremo en el norte y de un calor extremo en el sur. En Caracas estamos sufriendo un inusual calor de 28 grados cuando debería ser de 16/18 grados, y la actual sequia que ha vaciado el embalse hidroeléctrico de El Guri, ha obligado a aplicar restricciones de suministro y uso de energía eléctrica.

De acuerdo a lo anterior:

- No puede aún establecerce un vínculo entre las temperaturas glaciales con el fenómeno de El Niño

- No puede considerarse normal las nevadas en cotas muy bajas (Sevilla, Mexico, Florida)

- La ola de frío polar que afecta desde hace varias semanas a una gran parte del hemisferio norte se debe a un fenómeno conocido pero poco frecuente de "bloqueo"

- Nuevos datos muestran que el equilibrio entre la emisión de dióxido de carbono y la fracción absorbida por la atmósfera ha permanecido aproximadamente constante desde 1850, o sea, estos comportamientos inusuales no se deben al efecto invernadero.

La temperatura del Atlántico esta algo más fría este año. Sigo indagando en la red, a ver si consigo alguna publicación que mencione si se esta realizando algún estudio sobre la posible incidencia de un océano más frio en el "enfriamiento" de la Corriente del Golfo, y por ende, en que tengamos un invierno mas extremo en el norte del planeta. ¡Es para reflexionar!.

.bmp)